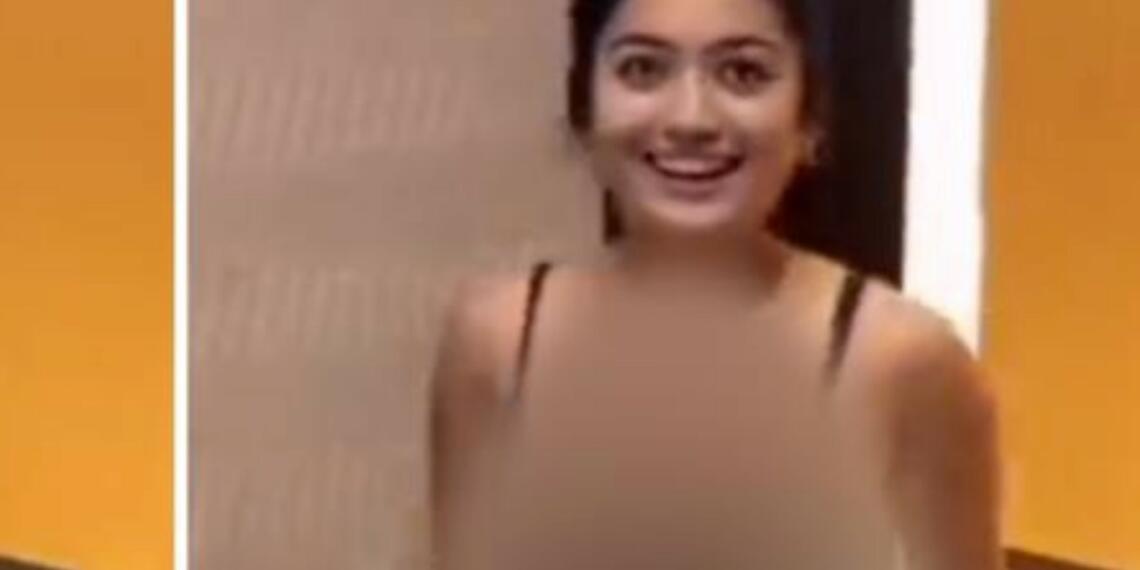

रश्मिका मंदाना, जो एक प्रसिद्ध अभिनेत्री हैं, हाल ही में दुर्भाग्यवश डीपफेक तकनीक का शिकार बन गई हैं। यह डिजिटल हेरफेर की तकनीक असली वीडियो में बदलाव कर, एक नकली वीडियो बनाती है। अभी रश्मिका मंदाना की एक नकली वीडियो सामने आई है, जिसने इंटरनेट पर फैल रहे इस तरह के फर्जी सामग्री से निपटने के लिए कानूनी और नियामकीय उपायों की तत्काल जरूरत को उजागर किया है।

जो विवादास्पद वीडियो विभिन्न सोशल मीडिया मंचों पर तेजी से फैल रहा है, उसमें रश्मिका मंदाना एक लिफ्ट में प्रवेश करती देखी जा सकती हैं। वीडियो में रश्मिका एक कामोत्तेजक परिधान पहने हुए है, जिसमें उनके स्तनों का एक बड़ा भाग दिख रहा है। इस कारण यह वीडियो वायरल हो गयी, और अकेले X पर 2.4 मिलियन से अधिक बार देखा गया।

हालांकि, गहन जांच पड़ताल के बाद, यह पता चला है कि यह वीडियो असली नहीं है बल्कि डीपफेक तकनीक की रचना है, जो किसी एक व्यक्ति की समानता को दूसरे पर चढ़ा कर असली दिखने वाली वीडियो बना सकती है। इस घटना से ऐसी तकनीकी दुरुपयोग की संभावित क्षति प्रकाश में आई है, खासकर सार्वजनिक हस्तियों के लिए। डीपफेक के प्रसार को संबोधित करने के लिए एक कानूनी ढांचे की तत्काल आवश्यकता है, ताकि व्यक्तियों को अनचाहे डिजिटल खतरे से बचाया जा सके।

डीपफेक तकनीक वीडियो संपादन और AI में एक महत्वपूर्ण छलांग है, जो अत्यंत असली वीडियो बनाने में मदद करती है। मशीन लर्निंग और फेस मैपिंग का उपयोग करते हुए, डीपफेक मानवीय चित्रों और आवाजों को बड़ी सटीकता के साथ प्रदर्शित करते हैं। यह लक्षित व्यक्तियों की उपस्थिति, चाल और भाषण पैटर्न की नकल करने के लिए बड़ी मात्रा में डेटा के साथ एल्गोरिदम्स, आम तौर पर जेनरेटिव एडवर्सरियल नेटवर्क्स (GANs), की ट्रेनिंग द्वारा की जाती है।

जहां डीपफेक मनोरंजन और शिक्षा जैसे क्षेत्रों में क्रांति लाने की संभावना रखती है, वहीं यह गहरी नैतिक और सामाजिक चिंताओं को भी उत्पन्न करती है। झूठी प्रस्तुतियाँ बनाने की इसकी क्षमता से गलत सूचना, प्रतिष्ठा को हानि, और डिजिटल मीडिया में विश्वास के कम होने का खतरा है। मान लीजिये किसी डीपफेक एडिटर ने किसी नेता की रिश्वत लेती हुई विडियो बना दी, ऐसे में तो राजनीति में, तो डीपफेक चुनाव की दशा और दिशा ही मोड़ सकती है.

असली सामग्री के साथ बिना किसी ख़ास अंतर के मिल जाने की डीपफेक्स की क्षमता, डिजिटल मीडियम में प्राइवेसी और कंसेंट के कानून की धज्जियां उड़ाती हुई दिखती हैं। डीपफेक्स के प्रसार को रोकने के तरीकों की तलाश जारी है, जिनमें प्रमुख है डिजिटल वॉटरमार्किंग और आइडेंटिटी सॉफ्टवेयर। हालांकि, तकनीक के लगातार विकसित होने के साथ, नकली सामग्री को असली फुटेज से अलग कर पाना और भी कठिन होता जा रहा है, जिससे डिजिटल युग में मीडिया साक्षरता की आवश्यकता और भी महत्वपूर्ण हो जाती है।

रश्मिका मंदाना ने खुद ट्विटर पर अपनी चिंता व्यक्त की। उन्होंने कहा:

I feel really hurt to share this and have to talk about the deepfake video of me being spread online.

Something like this is honestly, extremely scary not only for me, but also for each one of us who today is vulnerable to so much harm because of how technology is being misused.…

— Rashmika Mandanna (@iamRashmika) November 6, 2023

“मुझे सच में दुःख हो रहा है यह साझा करते हुए और इस बात पर चर्चा करते हुए कि मेरा डीपफेक वीडियो ऑनलाइन फैलाया जा रहा है।

इस तरह की चीज़ें सच में, बहुत डरावनी हैं न सिर्फ मेरे लिए, बल्कि हम सभी के लिए जो आज प्रौद्योगिकी के गलत इस्तेमाल की वजह से डरे हुए हैं।

आज, एक महिला और एक अभिनेता के रूप में, मैं अपने परिवार, दोस्तों और शुभचिंतकों के लिए आभारी हूँ जो मेरी सुरक्षा और समर्थन स्तम्भ हैं। लेकिन अगर यह मेरे साथ स्कूल या कॉलेज में होता, तो मैं सच में नहीं सोच सकती कि मैं इसका सामना कैसे कर पाती।

हमें एक समुदाय के रूप में इसका सामना करना है।”

दिग्गज अभिनेता अमिताभ बच्चन ने डीपफेक्स पर चिंता जताते हुए विवादास्पद वीडियो को शेयर किया और उन्होंने अपने ट्विटर अकाउंट पर कानूनी हस्तक्षेप की जरूरत पर बल दिया। बच्चन ने तुलना के लिए ब्रिटिश भारतीय ज़रा पटेल का असली वीडियो पोस्ट करके मुद्दे को और स्पष्ट किया। एक साथ देखने पर, डीपफेक और मूल वीडियो में अंतर स्पष्ट है। असली क्लिप में, एक अप्रवासी भारतीय ज़रा पटेल को स्पष्ट रूप से लिफ्ट में प्रवेश करते हुए देखा जा सकता है। हालांकि, फुटेज अचानक बदलती है, कुशलता से पटेल के चेहरे की जगह रश्मिका मंदाना का चेहरा लगा दिया जाता है।

yes this is a strong case for legal https://t.co/wHJl7PSYPN

— Amitabh Bachchan (@SrBachchan) November 5, 2023

डीपफेक वीडियो की पहचान:

डीपफेक वीडियो की पहचान अक्सर सूक्ष्म अवलोकन और कभी-कभी सॉफ़्टवेयर के उपयोग से की जा सकती है। यहाँ कुछ सुझाव और तकनीकें दी गई हैं जिनसे आप डीपफेक को पहचान सकते हैं:

अनियमितताओं की जाँच करें: प्रकाश में अनियमितताएं, धुंधले क्षेत्र, या चेहरे की विशेषताओं को देखें जो सही ढंग से संरेखित नहीं होतीं। प्राकृतिक भौतिकी का पालन न करने वाली छायाएं और परावर्तन स्पष्ट संकेत हो सकते हैं।

चेहरे की विसंगतियां: आंखों और होंठों पर ध्यान केंद्रित करें। डीपफेक अक्सर पलक झपकने की सटीकता को ठीक से नहीं दिखा पाते और आँखों की असामान्य गतिविधियां पैदा करते हैं। होंठों की सिंकिंग में प्रॉब्लम या असामान्य चेहरे के भाव भी कभी कभी देखे जा सकते हैं।

त्वचा की बनावट: त्वचा की बनावट बहुत चिकनी प्रतीत हो सकती है या प्राकृतिक रूप से प्रकाश को रिफ्लेक्ट करने में विफल रहती है। गर्दन के क्षेत्र में या जहां चेहरा बालों से मिलता है, वहां की त्वचा के टोन या बनावट में संक्रमण की समस्याएं देखें।

ऑडियो अनियमितताएं: आवाज के पैटर्न, टोन, या गुणवत्ता में किसी भी विसंगतियों के लिए सावधानी से सुनें जो हेरफेर को इंगित कर सकती हैं।

डिजिटल पदचिह्न: वीडियो के स्रोत की जांच करें। वीडियो या स्रोतों की कमी असत्यता का संकेत दे सकती है।

डीपफेक पहचान उपकरण: डीपफेक्स का पता लगाने के लिए उपलब्ध सॉफ़्टवेयर का उपयोग करें। ये उपकरण अक्सर ऐसे सूक्ष्म संकेतों और पैटर्नों की तलाश करते हैं जो मनुष्य अक्सर छोड़ देते हैं।

महत्वपूर्ण परीक्षण: संभावित रूप से सनसनीखेज या संदिग्ध सामग्री देखते समय संशयात्मक मानसिकता अपनाएं। फुटेज के संदर्भ और संभावना पर विचार करें।

सचेत रहना महत्वपूर्ण है, अक्सर सबसे प्रभावी उपकरण आपकी आंख ही होती है।